Khi Lời Cà Khịa Trên Reddit Biến Thành Hệ Thống Xử Lý Dữ Liệu Tỷ Đô: Chuyện Đời Không Như Là Mơ!

0

Kiến Trúc Xử Lý Dữ Liệu Thời Gian Thực Hiện Đại Với LLM và Apache Flink: Câu Chuyện Khởi Nguồn Từ Reddit

Mở Đầu

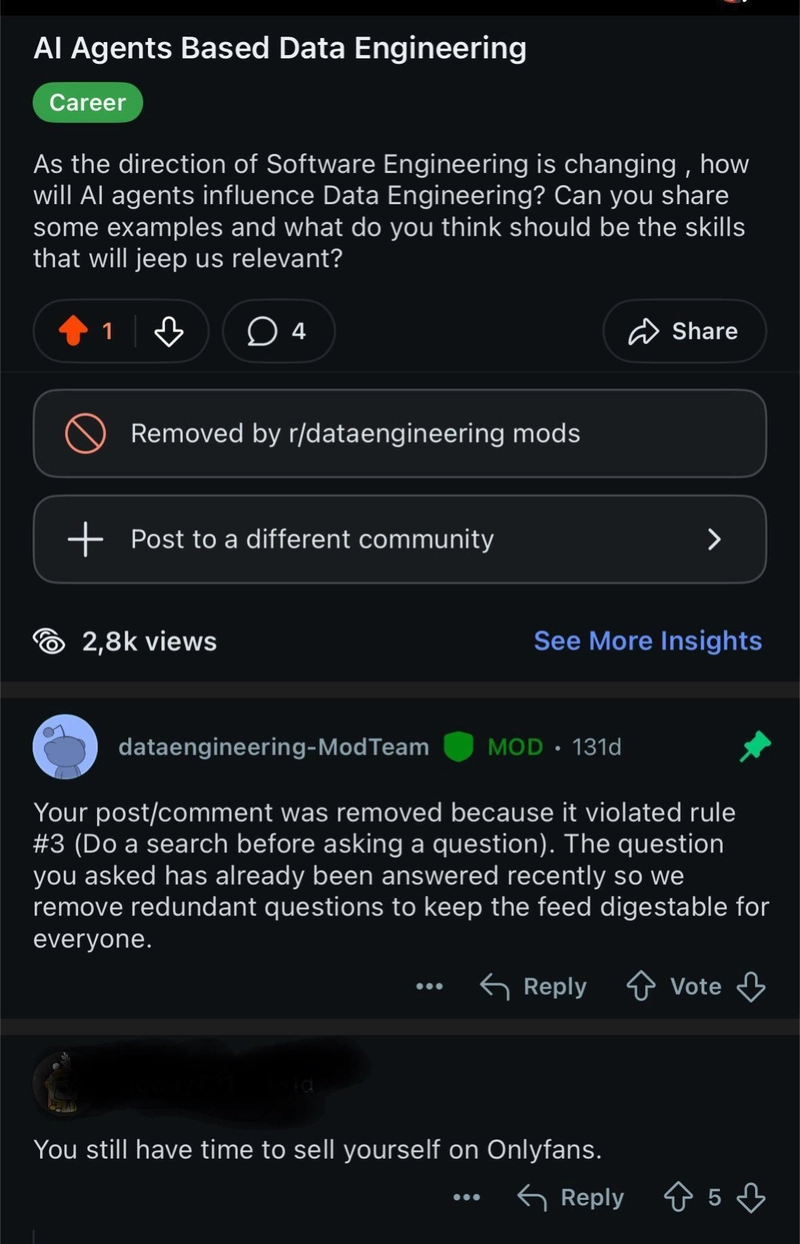

Khi một bình luận chế giễu trên Reddit bất ngờ trở thành nguồn cảm hứng lớn cho đổi mới công nghệ, bạn sẽ nghĩ thế nào? Câu chuyện dưới đây không chỉ kỳ quặc mà còn mở ra một hướng đi mới cho kiến trúc xử lý dữ liệu thời gian thực hiện đại.

Bạn là một kỹ sư dữ liệu đang tìm kiếm những xu hướng AI mới nhất để nâng cao kỹ năng? Thay vì nhận được câu trả lời nghiêm túc, bạn nhận một bình luận mỉa mai kiểu: "Bạn còn nhiều thời gian để đi bán hàng trên OnlyFans." Nhưng chính từ câu nói hài hước này, một hệ thống kỹ thuật phức tạp đã ra đời – một kiến trúc xử lý dữ liệu thời gian thực rộng lớn, sử dụng trí tuệ nhân tạo để tự động hoá triển khai và vận hành.

Bài viết này sẽ đưa bạn vào hành trình phát triển của hệ thống gồm ba thành phần chính: bộ phát sự kiện mô phỏng dữ liệu, dịch vụ triển khai điều khiển bằng ngôn ngữ tự nhiên qua LLM, và bộ xử lý sự kiện Apache Flink với sự hỗ trợ của kho dữ liệu Iceberg hiện đại. Cùng khám phá cách các công nghệ này kết hợp tạo nên một nền tảng xử lý dữ liệu doanh nghiệp với độ trễ cực thấp, linh hoạt và mở rộng dễ dàng.

1. Câu Chuyện Khởi Nguồn: Khi Bình Luận Hài Hước Truyền Cảm Hứng Đổi Mới

1.1. Ý Tưởng Bắt Đầu Từ Reddit

Khi một kỹ sư dữ liệu hỏi trên Reddit về các xu hướng AI mới để học, câu trả lời hài hước nhưng đầy châm biếm này lại trở thành chất xúc tác đổi mới:

"Bạn còn nhiều thời gian để đi bán hàng trên OnlyFans."

Thay vì bỏ qua, nhóm phát triển lấy câu nói làm thử thách: xây dựng một hệ thống xử lý dữ liệu trực tuyến quy mô lớn, ứng dụng AI tự động hoá deployment và giám sát hệ thống.

1.2. Định Hướng Kỹ Thuật

Hệ thống không chỉ để giải trí, mà còn bao gồm những mô hình kỹ thuật hiện đại:

- Tự động hóa vận hành DevOps bằng ngôn ngữ tự nhiên qua GPT-4

- Xử lý luồng sự kiện thời gian thực với Apache Flink

- Mô hình Data Lakehouse dùng Apache Iceberg, hỗ trợ ACID, schema evolution

- Kiến trúc hướng sự kiện sử dụng Kafka hoặc Redpanda

- Triển khai hạ tầng bằng Infrastructure as Code với Docker Compose

2. Kiến Trúc Hệ Thống: Ba Trụ Cột Của Xử Lý Dữ Liệu Hiện Đại

2.1. Event Publisher – Bộ Phát Sự Kiện Mô Phỏng

Bộ phát sự kiện sử dụng Go để tạo luồng dữ liệu mô phỏng, cấu hình linh hoạt:

- Số lượng thiết bị mô phỏng (từ 1 đến N)

- Tần suất phát dữ liệu từ mili giây đến vài phút

- Chế độ tiêm nhiễu bất thường 5% để mô phỏng sự kiện quan trọng

Dữ liệu mô phỏng là nhiệt độ GPU thay cho các dữ liệu sensor khác, phù hợp cho IoT, giám sát hạ tầng.

Dữ liệu được đẩy lên nền tảng Kafka (ở đây dùng Redpanda) thành các topic sự kiện liên tục, có thể dễ dàng mở rộng nhiều node và tích hợp Docker để vận hành dễ dàng.

Điểm quan trọng: Việc mô phỏng dữ liệu đa dạng và cấu hình linh hoạt giúp hệ thống dễ dàng ứng dụng trong nhiều lĩnh vực: từ giám sát hạ tầng đến phân tích hành vi người dùng.

2.2. LLM-Powered Deployment Service – Lớp Triển Khai Điều Khiển Bằng AI

Thay vì dùng script triển khai thủ công hoặc pipeline CI/CD phức tạp, nhóm phát triển sử dụng GPT-4 làm trung gian nhận diện câu lệnh tự nhiên và tự động:

- Phân tích và chuyển đổi ngôn ngữ tự nhiên sang lệnh cụ thể

- Tự động tạo và triển khai job Apache Flink

- Triển khai linh hoạt bằng Docker hoặc CLI tùy môi trường

- Tích hợp cơ chế retry, giám sát hiệu quả

Ví dụ các câu lệnh:

- "deploy content event processor"

- "start processing video events"

- "I need creator analytics running"

Hệ thống sẽ giải mã và kích hoạt pipeline xử lý tương ứng.

Tham khảo: Người vận hành có thể chỉ cần nhập câu lệnh tiếng Anh đơn giản mà không cần nhớ chi tiết cấu hình phức tạp.

2.3. Flink Event Processor – Động Cơ Xử Lý Luồng Sự Kiện

Lõi hệ thống là ứng dụng Apache Flink xử lý dữ liệu luồng với các đặc điểm:

- Real-time, low latency (sẽ checkpoint mỗi 30 giây)

- Đảm bảo exactly-once processing

- Hỗ trợ đồng thời nhiều loại sự kiện: content, creator, nhiệt độ GPU,...

- Tích hợp Apache Iceberg làm storage, hỗ trợ ACID, xử lý schema và time travel

Kiến trúc xử lý sự kiện:

Thành Phần | Chức Năng |

|---|---|

Kafka Source | Đưa dữ liệu sự kiện vào Flink |

Flink Stream | Chuyển đổi, xác thực, enrichment |

Iceberg Tables | Lưu trữ dữ liệu với ACID |

env.enableCheckpointing(30000);env.getCheckpointConfig().setCheckpointingMode(CheckpointingMode.EXACTLY_ONCE);

BaseEventProcessor processor = factory.createProcessor(eventType);processor.buildPipeline(env).execute();Đặc điểm nổi bật: Mô hình mở rộng cho nhiều loại dữ liệu, đảm bảo tính nhất quán và khả năng mở rộng linh hoạt.

3. Những Đổi Mới Kỹ Thuật Nổi Bật

3.1. Tự Động Hóa Hạ Tầng Bằng LLM

Việc ứng dụng GPT-4 làm lớp điều khiển giúp đối chiếu yêu cầu ngôn ngữ tự nhiên với các lệnh kỹ thuật, giảm thiểu sai sót và hỗ trợ nhanh chóng khi xử lý deployment, monitor.

3.2. Kiến Trúc Hybrid – Song Hành Container & CLI

Hỗ trợ cả hai phương pháp triển khai bằng Docker container và Flink CLI giúp hệ thống dễ dàng tích hợp linh hoạt với các hạ tầng hiện có và môi trường phát triển khác nhau.

3.3. Data Lakehouse Hiện Đại Với Apache Iceberg

Sử dụng Iceberg giúp giải quyết vấn đề consistency, bảo trì schema, lưu lịch sử dữ liệu dễ dàng, tối ưu partition giúp tăng tốc độ truy vấn dữ liệu.

4. Hiệu Suất và Mở Rộng

Thành Phần | Cấu Hình Chính | Mục Tiêu |

|---|---|---|

Apache Flink | Parallelism = 4 Checkpoint kịp thời | Tăng throughput, giảm độ trễ |

Kafka Consumer | Min fetch = 1MB Max fetch = 10MB | Tối đa băng thông, giảm độ trễ truy xuất |

Docker Orchestration | Health checks, logging | Đảm bảo ổn định hệ thống và giám sát |

Hệ thống đảm bảo vận hành ổn định trong môi trường sản xuất với kiểm soát lỗi, tự động retry và giám sát qua Flink Web UI, log và lag monitoring.

5. Ứng Dụng Thực Tế Và Bài Học Kỹ Thuật

5.1. Ứng Dụng Sản Phẩm

- Hệ thống phân tích video và nội dung

- Tối ưu tương tác người dùng trên nền tảng mạng xã hội

- Giám sát sensor IoT, phát hiện bất thường

- Dự báo bảo trì trong công nghiệp

- Phân tích hành vi thương mại điện tử, rủi ro tài chính

5.2. Bài Học Kinh Nghiệm

- Tích hợp LLM cần xử lý kỹ lưỡng lỗi và bảo mật để tránh sai sót nguy hiểm

- Phối hợp đa ngôn ngữ (Go cho dịch vụ LLM, Java cho Flink) tối ưu lợi thế mỗi nền tảng

- Thiết kế kiến trúc stream processing theo các pattern như Factory, Strategy, Builder để dễ bảo trì và mở rộng

6. Tương Lai Phát Triển

6.1. Nâng Cao Khả Năng LLM

- Triển khai các lệnh đa bước, triển khai phức tạp hơn

- Tối ưu tài nguyên dựa trên phân tích tự động

- Hệ thống AI hỗ trợ chẩn đoán lỗi tự động

6.2. Tăng Cường Xử Lý Luồng

- Kết hợp học máy thời gian thực (feature engineering, model serving)

- Phát hiện sự kiện phức tạp trên đa luồng dữ liệu

- Tự động điều chỉnh song song theo tải

6.3. Hoàn Thiện Vận Hành

- GitOps để quản lý cấu hình deployment

- Hỗ trợ đa nhóm sử dụng đa môi trường

- Mở rộng monitoring với các chỉ số tuỳ chỉnh và cảnh báo thông minh

Kết Luận

Từ một câu nói bông đùa trên Reddit, hệ thống xử lý dữ liệu thời gian thực này đã trở thành minh chứng cho sự sáng tạo trong kỹ thuật hiện đại. Với việc kết hợp trí tuệ nhân tạo, kiến trúc hướng sự kiện, công nghệ streaming và data lakehouse, đây chính là mô hình tham khảo cho nhiều ứng dụng thực tế trong tương lai.

Hành động đề xuất: Nếu bạn đang nghiên cứu hoặc phát triển hệ thống xử lý dữ liệu quy mô, hãy cân nhắc tích hợp các xu hướng LLM và kiến trúc hybrid như trên để tăng tính tự động hóa và tối ưu hiệu suất.

Tham Khảo

- Snepar GitHub Repositories:

- Event Publisher

- LLM Service

- Flink Processor

- Apache Flink Documentation - https://flink.apache.org/

- Apache Iceberg Official Site - https://iceberg.apache.org/

- OpenAI GPT-4 API Reference - https://openai.com/api

- Redpanda Messaging Platform - https://redpanda.com/

May 29, 2024

1

100%

Loading...